EtoloGuía (1997) 15:17-30

LA REFERENCIA BIBLIOGRÁFICA COMO MEDIDA DE ‘UTILIDAD CIENTÍFICA’

Luis

M. Carrascal

Museo Nacional de Ciencias Naturales

Consejo Superior de Investigaciones Científicas

INTRODUCCIÓN

La referencia bibliográfica como ‘deuda intelectual’

Sesgos en el valor de las citas

Utilidad 'prudente' de las citas bibliográficas

MEDIDAS DERIVADAS DEL USO DE CITACIONES

Indice de impacto

Sesgos en los índices de impacto

Vida media de los artículos científicos

Indice de inmediatez

... Y EL ‘SCI’ SE HIZO CARNE Y HABITÓ ENTRE NOSOTROS

¿Ilustran los índices de citación las revistas que más

leemos y preferimos citar?

¿Cuánto tiempo pasan desapercibidos nuestros trabajos hasta

citarse?

¿Pueden predecir los índices de impacto de las revistas la

frecuencia con la que se citarán nuestros trabajos?

¡Ya, ya!, pero diferentes disciplinas no se pueden comparar

¿Pueden predecir los índices de impacto la frecuencia con la

que todo mi trabajo se citará en un año determinado?

REFERENCIAS BIBLIOGRÁFICAS Y VÍNCULOS WEB

Otro trabajo relacionado (publicado en Ardeola [1998] 45:221-239):

UTILIDAD CIENTÍFICA Y DIFUSIÓN INTERNACIONAL DE ARDEOLA:

UN ANÁLISIS BIBLIOMÉTRICO.

Aunque la publicación en foros especializados no es el único vehículo de difusión de ideas, si es cierto que es la herramienta más estructurada de comunicación científica. A través de publicaciones especializadas, sean revistas o libros científicos, nuestro trabajo de investigación (1) pasa un filtro selectivo efectuado por otros colegas, (2) sitúa nuestra contribución en un marco teórico y en el contexto del conocimiento existente, (3) pormenoriza nuestros protocolos, diseños e instrumentación para que puedan ser repetibles y refutados en caso necesario, y (4) presenta los resultados sin ambigüedad con el objeto de derivar de ellos ideas inéditas (Day 1994). Todo este proceso nos protege frente a la repetición de estudios previamente hechos y el redescubrimiento del conocimiento existente. Esto es especialmente importante en una época de enorme producción científica donde los recursos económicos para investigar y publicar son limitados, y las tasas de rechazo muy elevadas (>60% en muchísimas revistas; por ejemplo, Calow 1997).

Por otro lado, trabajando con especies que pueden estar amenazadas, o ser sensibles a nuestras molestias por manipulación o estudio, es sumamente importante conocer lo previamente publicado para no repetir cansinamente las mismas cosas en diferentes localidades. Este carácter repetitivo y local de ciertos trabajos es más propio de una actividad científica provinciana carente de vocación universal. Téngase en cuenta que esta última afirmación de ninguna manera pretende descalificar los necesarios trabajos prácticos de carácter técnico que se expresan bajo la forma de informes de reducida difusión, sino acotar el marco de la investigación científica como actividad que pretende generar conocimiento relevante, universal y predictivo referente a nuestro entorno.

Las referencias a trabajos previos simbolizan asociaciones conceptuales de ideas científicas reconocidas como útiles e interesantes por el autor que las cita. Dicho de otro modo, una cita es una transacción intelectual, un reconocimiento expreso de una ‘deuda intelectual’ hacia una fuente de información previa. Mediante las referencias citadas en los trabajos científicos, los investigadores establecemos vínculos entre nuestra investigación en curso y el trabajo previo recopilado en la literatura científica (Garfield 1994a y referencias allí dadas). Estas referencias implican que los autores hemos encontrado de utilidad el conocimiento publicado por otros (teorías y modelos, hipótesis, metodologías, descripciones de especies o fenómenos, nuevas fronteras de investigación, etc). Incluso en el caso de que las referencias a otros autores sean negativas, esto no tiene porqué indicar que la investigación citada haya sido inútil, ya que puede promover discusión y crítica que identifica errores que es necesario subsanar para continuar progresando en una disciplina (Simonton 1988).

- el tipo de artículo (e.g., las revisiones y los artículos metodológicos reciben más citas que los de investigación; las notas suelen citarse menos que los artículos largos),

- las autocitas de los propios trabajos que son mudos para el resto de la comunidad científica (i.e., no son citados nunca por otras personas),

- el ‘efecto colegio invisible’ (elevada frecuencia de citas de los trabajos de un grupo de personas como consecuencia de relaciones de amistad o de poder que no tienen que ver con la calidad y utilidad del trabajo científico citado),

- el ‘efecto persuasivo’ (citas a personas con las cuales se establecen vínculos de deuda o dependencia; de cara a futuras oposiciones, concursos, posibilidad de evaluación de proyectos, etc),

- el efecto ‘cita a ciegas’ (citar referencias bibliográficas de artículos no leídos que se repiten una y otra vez en trabajos recientes, independientemente de su ‘utilidad real’; la referencia a unos pocos trabajos es sobredimensionada por la selección de referencias efectuada por un reducido número de autores que inician una línea de investigación),

- la competencia desleal (los trabajos de otros investigadores que trabajan en la misma disciplina son ignorados, aunque a veces se puedan copiar frases y párrafos enteros sin ser citados; ver Maddox 1995 para un espectacular caso de plagio),

- el retraso hasta el reconocimiento de la utilidad (e.g., el trabajo tremendamente relevante de Gregor Mendel fue ignorado por sus coetáneos y posteriormente durante muchos años).

No obstante estos sesgos, las citas poseen una elevada utilidad en el campo científico. Así, ayudan a distinguir al ‘productor masivo’ de trabajos silenciosos e irrelevantes (estrategia que jocosamente denomino ‘curriculum al peso’ que tanto ha primado y sigue primando en numerosas oposiciones de nuestro país), del ‘perfeccionista’ dedicado al trabajo pausado para producir pocas contribuciones de gran trascendencia y refrendo por la comunidad científica internacional (habitualmente descartado por los tribunales; numerosos científicos célebres del siglo pasado y principios de éste no hubieran superado la primera prueba de muchas oposiciones, debido a su bajísima producción científica en términos de número de publicaciones; Sangalli 1995). Estos suelen ser dos puntos perdidos dentro de la relación positiva generalizada entre cantidad y calidad de la producción intelectual (observado en literatura, música, investigación científica, etc; Simonton 1988).

Las citas de los investigadores, o las tasas de citación de las revistas donde estos publican, se emplean cada vez más a la hora de juzgar ‘de modo objetivo’ la calidad científica de los individuos, los grupos de investigación, los departamentos, centros, países etc (Wade 1975; Statzner et al. 1995; e.g., EL PAIS, 8 Octubre 1997, pág. 27). La lógica del argumento es aplastante: a la hora de valorar la calidad de las contribuciones científicas de un individuo o grupo, la consideración y consecuente cita de numerosos investigadores (muchos miles) distribuidos por todo el mundo (sentido universal de la ciencia), tiene más valor y muchas menos fuentes de sesgo que la opinión de tres, cinco o, en el mejor de los casos, siete miembros de tribunal, que además suelen estar ‘emparentados intelectualmente’ con algunos de los candidatos (cumplimiento de los aspectos críticos 3, 4 y 6 de los sesgos de las citaciones).

De todas maneras, y como puede comprobarse con la experiencia de investigadores italianos (por ejemplo, Nature 1995, 374:492; 1995, 376:720), las citas y el índice de impacto de las revistas deben contemplarse con prudencia, y ser utilizados en conjunción con otros criterios (Garfield 1994b, 1994c; Statzner 1995 y referencias allí dadas). Más aún, ciertos autores han propuesto que el empleo frío de las tasas de citación pueden causar daños a determinadas disciplinas (Tainer 1990), ya que pueden verse favorecidas circularmente aquellas más potenciadas económicamente (con más medios económicos y personal científico), o aquellas que están de moda independientemente de la calidad y perdurabilidad de sus logros (a todos nos vienen a la mente varias líneas temáticas que han surgido repentinamente debido a espaldarazos políticos o de los medios de comunicación).

En buena lógica, y desde el punto de vista del ejercicio mesurado de la ingrata evaluación de los demás, las tasas de citación nunca deberían ser utilizadas exclusivamente, debido a los sesgos potenciales expuestos anteriormente. No obstante, y a juzgar por la experiencia pasada y reciente en nuestro país, el problema no ha sido su uso incorrecto, sino la ausencia de su empleo. Por desgracia, en nuestro país ha primado la utilización de criterios locales, endogámicos y basados en el nepotismo en algunas ocasiones (recomiendo la lectura de Ramón y Cajal 1991, y pensar en algunos casos actuales más o menos flagrantes que conocemos). Mi visión particular del asunto es que el empleo de las citas y las tasas de citación son un complemento muy útil en la evaluación científica, si, y sólo si, entendemos su significado y somos capaces de utilizarlos correctamente. De todos modos, y a pesar de los problemas identificados anteriormente, también considero que son el mejor antídoto frente a la endogamia intelectual y el nepotismo en el mundo académico.

Por último, las citaciones también pueden ser utilizadas a la hora de decidir qué revistas comprar para la biblioteca de un centro o departamento cuando el presupuesto es reducido, o es recortado por imposiciones económicas institucionales o nacionales (Garfield 1994b y referencias allí dadas). Otra curiosa utilización ha sido la comparación del poder o ‘salud’ científica de diferentes países, práctica que en no pocas ocasiones presenta ribetes etnocéntricos (e.g., May 1997).

MEDIDAS DERIVADAS DEL USO DE CITACIONES

El Institute for Scientific Information (ISI; Philadelphia, USA) compila cada año todas las referencias bibliográficas aparecidas en cerca de 8.000 revistas científicas de 3.000 editoriales y 102 países. A partir de toda esta información, los investigadores pueden valorar cómo su trabajo es referenciado por una enorme comunidad científica. Baste sólo un ejemplo: en las 85 revistas internacionales más frecuentemente consultadas por el autor de este trabajo (ecología, etología, evolución, biogeografía, ecofisiología, morfología, ornitología, herpetología, mastozoología) han aparecido en los últimos 30 meses (1995-1997) 17.100 artículos de 23.455 autores diferentes que citan 600.000 referencias bibliográficas (datos obtenidos a partir del Current Contents en disquete y del Journal of Citation Reports). Además de conocer el ‘uso científico’ de artículos concretos, o la difusión global del trabajo de un investigador, grupo, departamento o centro, también es posible obtener índices medios relativos a disciplinas enteras o revistas particulares.

Uno de los parámetros más utilizado es el índice de impacto de una revista (Garfield 1994b; conocido vulgarmente como SCI): es una medida de la frecuencia con la que el ‘artículo medio’ de una revista ha sido citado en un período particular de tiempo. Tal y como se tabula anualmente en los Journal of Citation Reports del ISI, resulta de dividir el número de citas recibidas en un año concreto por los artículos publicados en una revista determinada los dos años previos, por el número de artículos que dicha revista publicó en ese mismo período. Por ejemplo, el índice de impacto de la revista Behaviour en 1995 se calcula como el total de citas recibidas en 1995 por los artículos publicados en 1993 y 1994 por dicha revista, dividido por los artículos que Behaviour publicó en 1993-1994.

citas en 1995 a los artículos publicados en 1993 y 1994

índice de impacto en 1995 = —————————————————————————————————————————————————————————

artículos publicados en 1993 y 1994

Este índice tiene una fuerte componente de inmediatez ya que trabaja con un período muy restringido y reciente de tiempo. Comparando disciplinas distintas se observan diferencias que pueden llegar a ser de hasta un orden de magnitud. Por ejemplo, el índice medio de impacto de las tres revistas con más tasa de citación de diferentes disciplinas varió del siguiente modo en 1995: Química (18,1), Geología (2,0), Biología Molecular (38,5), Genética (19,3), Ecología (5,2), Etología (excluyendo neurofisiología; 2,0), Ornitología (1,0), Herpetología (0,6). Es obvio que las disciplinas taxonómicas no tienen mucho sentido debido a que sus trabajos pueden aparecer en otras de carácter temático (e.g. ecología, etología), pero estos pocos datos ilustran la enorme variabilidad observada en las tasas promedio de citación del ‘artículo medio’ de revistas de diferentes disciplinas.

Sesgos en los índices de impacto

Ante esta variabilidad la pregunta que surge es inmediata: ¿es más útil la Biología Molecular que la Genética, o la Genética que la Ecología, o la Ecología que la Etología, por el mero hecho de que unas disciplinas son más citadas que otras? Metcalfe (1995) y Statzner (1995) muestran, comparando distintas disciplinas, que estas enormes variaciones dependen de ciertas variables que inducen a confusión. Las revistas pertenecientes a disciplinas con menores lapsos de tiempo entre el envío del manuscrito y la publicación definitiva son citadas más frecuentemente (retraso medio de 16 meses en Ecología, frente a 6 meses en Biología Molecular). Las revistas que recurren a la cita de trabajos publicados muy recientemente también presentan mayor índice de impacto (% de artículos citados que fueron publicados en los dos últimos años: Ecología=9,5% frente a Biología Molecular=28,2%). En el estudio de Metcalfe (1985), estas dos variables explicaban el 72% de la variabilidad observada en los índices de impacto de diferentes disciplinas. Statzner (1995) también propone que los índices de impacto dependen del número de publicaciones anuales en cada disciplina (cantidad de la producción científica), la duración de los trabajos de investigación antes de su publicación, y la conexión entre distintas disciplinas.

Considerando estas variables distorsionadoras, sería conveniente utilizar escalas relativas dentro de cada disciplina, sin entrar en consideraciones métricas de índices de impacto. Si personas o grupos de diferentes disciplinas se ven obligados a competir por unos recursos limitados, sería mucho más conveniente utilizar posiciones relativas respecto a valores medios dentro de cada área de conocimiento. Por ejemplo, número de trabajos científicos publicados en el 20 % de las revistas más citadas de una disciplina; reordenación de los índices de impacto desde 0 a 10, dando el valor de 10 a la revista con mayor tasa de citación; re-escalar las citas recibidas por los autores en un tiempo determinado teniendo en cuenta el índice medio de impacto del 20 % de las revistas más citadas en su disciplina, etc.

Vida media de los artículos científicos

Con el paso del tiempo los artículos científicos dejan de citarse. Esto es, su ‘vida intelectual’ se va extinguiendo hasta que desaparecen de los listados de referencias bibliográficas. Sólo unos pocos perduran durante prolongados períodos de tiempo (e.g., ‘El Origen de las Especies’ de Darwin, método de tinción del tejido nervioso de Ramón y Cajal). Un índice que valora este fenómeno (evolución temporal de las tasas de citación de las revistas) es la vida media de citación del ‘artículo medio’ de una revista (Garfield 1994c). Este parámetro mide el número de años transcurridos desde la actualidad hacia el pasado que acogen el 50% del número total de las citas de una revista determinada. En principio, los artículos que más perduran en el panorama científico, siendo citados, son contribuciones más útiles. Combinando el índice de impacto y la vida media de citación mediante su multiplicación, podríamos obtener una medida más realista de una ‘métrica de la utilidad científica’.

Cuan rápido aparecen citados por primera vez los trabajos

Por último, el índice de inmediatez valora cuan rápidamente el ‘artículo medio’ de una disciplina es citado. Este índice varía enormemente, pudiendo ser muy alto en Biología Molecular, Inmunología y Genética (>2) y muy bajo en Ecología y Zoología (<0,5). Para una revista determiada X, este índice se calcula del siguiente modo:

citas en 1995 a los artículos publicados por X en 1995

índice de inmediatez en 1995 = ——————————————————————————————————————————————

artículos publicados por X en 1995

En la Tabla 1 se ilustran estos índices para algunas de las revistas científicas más citadas en distintas disciplinas, y para todas las de Etología-Ecología de la Conducta. Un análisis comparado de los datos de esta tabla puede ayudar a comprender los índices anteriormente formulados.

|

Revista |

Disciplina |

Índice impacto |

Vida media |

Índice inmediatez |

|

Nature |

Multidisciplinar |

25 |

6.1 |

5.7 |

|

Cell Biología |

Molecular |

39 |

4.4 |

6.5 |

|

P. Roy. Soc. Lond. B. |

Biología-Evolución |

2.8 |

>10.0 |

0.4 |

|

Am. Nat. |

Ecología |

2.9 |

>10.0 |

0.5 |

|

J. Appl. Ecol. |

Ecología Aplicada |

1.1 |

>10.0 |

0.2 |

|

Biol. Cons. |

Biología-Conservación |

0.9 |

6.5 |

0.3 |

|

J. Zool. (Lond.) |

Zoología |

0.7 |

>10.0 |

0.2 |

|

Auk |

Ornitología |

0.9 |

>10.0 |

0.2 |

|

Herpetologica |

Herpetología |

0.8 |

>10.0 |

0.2 |

|

J. Mammal. |

Mastozoología |

0.7 |

>10.0 |

0.1 |

|

Ecol. Entomol. |

Entomología |

1 |

7.7 |

0.1 |

|

Behav. Ecol.* |

Etología |

2.4 |

3.5** |

0.4 |

|

Behav. Ecol. Soc.* |

Etología |

1.9 |

7.4 |

0.2 |

|

Anim. Behav. |

Etología |

1.7 |

7.5 |

0.4 |

|

Behaviour |

Etología |

0.9 |

>10.0 |

0.3 |

|

Ethology |

Etología |

1 |

5.2 |

0.2 |

|

Behav. Proc. |

Etología |

0.6 |

7.5 |

0.1 |

|

Ethol. Ecol. Evol. |

Etología |

0.4 |

4.0** |

0 |

... Y EL ‘SCI’ SE HIZO CARNE Y HABITÓ ENTRE NOSOTROS.

A continuación voy a ilustrar distintos aspectos de la citación y los índices de impacto con datos tomados de tres investigadores del Departamento de Ecología Evolutiva del Museo Nacional de Ciencias Naturales. El objetivo último es mostrar que las citaciones y los índices de impacto no son entelequias, sino aspectos que se repiten y cumplen en las vidas profesionales de los investigadores científicos.

Entre estos aspectos se encuentran, por ejemplo, la identificación de trabajos clave que han producido un considerable impacto en la comunidad científica internacional. Este ya es un criterio que se contempla en la evaluación de los Sexenios de Productividad Científica (B.O.E., 20 Noviembre 1996, 280:35.028, puntos 3 y 4-c). Por otro lado, también podemos utilizar las citaciones para evaluar retrospectivamente nuestra carrera investigadora: ¿por qué trabajando en este tema se me ha citado menos que ese otro?, ¿por qué este trabajo se cita menos que ése, siendo ambos del mismo tema?, ¿influyen los títulos que pongo a mis trabajos en su citación temprana?, etc.

Los análisis que a continuación se presentan se han efectuado

con tres carreras investigadoras centradas en Evolución, Ecología y Etología

Animal. Los tres investigadores seleccionados son un ejemplo de un rango

relativamente amplio de duración de su carrera investigadora: Luis M. Bautista

(Tesis Doctoral defendida en 1992), Luis M. Carrascal (TD=1987), Juan Moreno

(TD=1983). Mediante diferentes modelos de ANCOVA se comprueba que no existen

diferencias significativas entre estas tres personas, por lo cual los

resultados se expondrán sin distinguir entre investigadores.

¿Ilustran los índices de citación las revistas que más leemos y preferimos citar?

De la selección hecha por los tres investigadores de sus cinco trabajos más destacados, se han extraido las referencias bibliográficas citadas. En total se han obtenido 701 referencias para 15 artículos científicos (media=46,7 referencias / artículo). El porcentaje de autocitas ha sido el 11%, con lo cual las referencias han sido mayoritariamente hacia el trabajo de los demás. Los investigadores analizados afirman que los artículos que han referenciado en sus bibliografías los valoran muy positivamente, y han sido de tremenda utilidad para su trabajo. Esto es, no han citado lo malo y lo que no les gusta (para despejar cualquier duda sobre el posible significado negativo de las referencias utilizadas).

Aunque existe un sesgo temático de manera que no todas las revistas de elevado índice de impacto han sido citadas con una elevada frecuencia por estos tres investigadores en sus 15 artículos, sí es cierto que las más citadas tienen mayores índices de impacto. Así, todas las revistas que acaparan, al menos, el 2% o más de las 701 citas (Ornis Scandinavica, Ibis, Auk, Condor, Ardea, Nature, Ecology, American Naturalist, Journal of Animal Ecology, Oecologia, Ecological Monographs, Animal Behaviour y Behavioural Ecology and Sociobiology) presentan elevados índices de impacto en el SCI (0,7-3,0). Más aún, las 13 revistas más citadas (<10% del total de publicaciones-revistas diferentes citadas al menos una vez) captan el 46% del total de las citas. Esto es, en la muestra de 15 artículos científicos y 701 referencias ‘no están todas las que son, pero sí son todas las que están’. Por otro lado, unas pocas revistas captaron mayoritariamente la atención y lectura de estos tres investigadores, siendo las principales responsables de su enriquecimiento científico a la hora de contribuir a la comunidad científica internacional con sus trabajos.

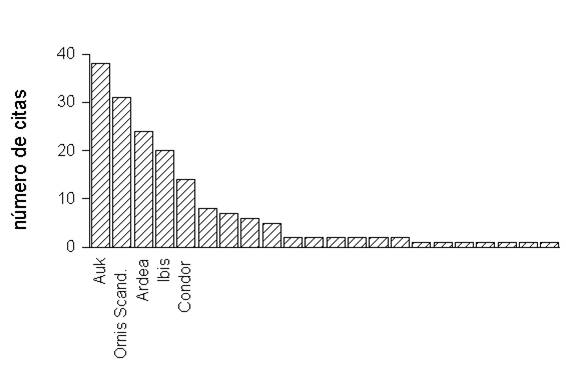

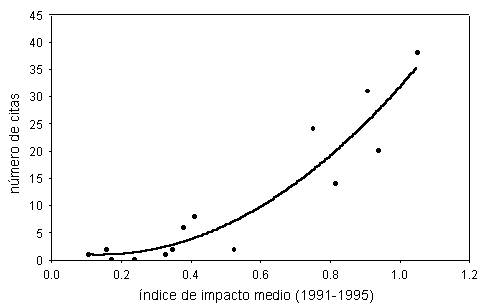

Debido al sesgo taxonómico de su trabajo (aves como sujetos de estudio), entre las 701 referencias de los 15 trabajos seleccionados predominan las de revistas ornitológicas (116 citas). Incluso con esta reducida muestra es posible ilustrar dos importantes hechos. Por un lado, la Figura 1 muestra un fenómeno universal en el proceso de producción intelectual y su uso por amplias comunidades (Simonton 1988): la inmensa mayoría de la producción científica pasa desapercibida, recibiendo la máxima atención sólo unos pocos foros o publicaciones (véase cómo 5 revistas captan la gran mayoría de las citas bibliográficas). Por otro lado, la Figura 2 pone de manifiesto que existe un fortísima relación entre las veces que se citó cada revista y su índice de impacto medio (calculado para los años 1991-1995 utilizando las revistas incluidas en los Journal Citation Reports; R2=0,75, n=14, p<<0,001).

CONCLUSIÓN: Ante las añagazas de los detractores de las referencias bibliográficas como medio válido para aproximarnos a la relevancia y potencial de difusión de las publicaciones científicas, podríamos decir: PUBLICA EN LAS REVISTAS QUE CON MAYOR FRECUENCIA LEES Y CITAS EN TU BIBLIOGRAFÍA. A la postre, acabaremos convergiendo con el SCI tras una larga (¡y no tan larga!) carrera científica con proyección universal (¿y no debe ser éste el espíritu de centros que, como la Universidad, tienen como meta impartir conocimiento Universal?).

¿Cuánto tiempo pasan desapercibidos nuestros trabajos hasta citarse?

A partir de los Science Citation Reports (ISI; disponibles en el CINDOC, CSIC, Madrid) se han buscado las citas que los tres investigadores analizados han cosechado desde que iniciaron su carrera científica. Con el objeto de reducir sesgos, se han descartado aquellas referencias que eran autocitas, o citas cruzadas (el autor A cita el trabajo de B, en el cual el aparece como coautor). Esto es, con los datos obtenidos se calculan tasas de citación honestas que excluyen uno de los sesgos potenciales: la autocita (tasa de autocita de los tres investigadores analizados=11%).

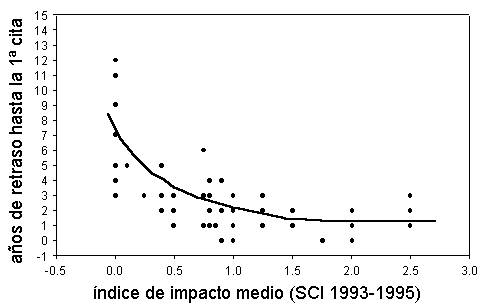

El retraso medio hasta la primera cita (no autocita) ha sido 3,0 años (sd=2,8, n=71 artículos citados, al menos, una vez). El índice de inmediatez de nuestro trabajo ha sido 0,07 (citas/año el mismo año de la publicación del trabajo). No obstante, dentro de estos valores medios se esconde una tremenda variabilidad. Así, los trabajos publicados en revistas no incluidas en el SCI tienen un retraso medio de 7,1 años (sd=3,4, n=14 artículos), que es significativamente mayor que el de los publicados en revistas incluidas en los listados del SCI (2,0 años, sd=1,4, n=57; test de la U de Mann-Whitney, p<0,001). La Figura 3 muestra la relación negativa existente entre el retraso hasta la primera cita, y el índice de impacto medio en 1993-1995 de las revistas donde se han publicado los 71 trabajos considerados (R2=0,50, p<<0,001).

Conclusión: Si queremos que nuestro trabajo pase la menor cantidad de tiempo posible desapercibido hasta ser reconocido como útil y citado, deberíamos publicar principalmente en las revistas con máxima difusión y tasa de citación. De no ser así, los estamos condenando al ostracismo. SI QUEREMOS QUE NUESTRO TRABAJO SEA UTILIZADO A LA MAYOR BREVEDAD POSIBLE, PUBLIQUEMOS EN LAS REVISTAS CON MAYORES ÍNDICES DE IMPACTO.

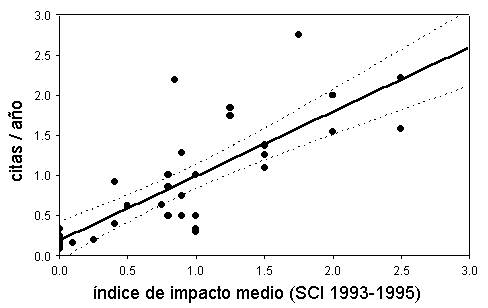

Con los datos de citas es posible calcular los índices de impacto de cada trabajo particular. Para ello se divide el número de citas recibidas, entre el número de años transcurridos desde la publicación. Aunque este índice es conceptualmente idéntico al índice de impacto del SCI, difiere en la práctica, ya que no se calcula solamente para los dos primeros años a partir de la publicación (los tiempos para efectuar la estima han oscilado entre 2 y 15 años). Con las 71 publicaciones de los tres autores seleccionados que han recibido, al menos, una cita se han obtenido los índices de impacto. Posteriormente se han calculado los índices de impacto medio por revista (6 no incluidas en los Journal of Citation Reports, y 30 sí incluidas).

La Figura 4 muestra que existe una estrechísima relación entre los índices de impacto medios de las revistas utilizando los datos de toda la comunidad científica (SCI para los años 1993-1995), y los índices de impacto calculados para las revistas donde han publicado los tres investigadores seleccionados (R2=0,63, n=36 revistas diferentes, p<<0,001; téngase en cuenta que los índices de impacto para los trabajos de los tres investigadores considerados no incluyen autocitas).

Conclusión: Los índices de impacto tienen valor prediciendo las tasas medias de citación de nuestros trabajos. La base de este fenómeno está en que en los foros de más índice de impacto, las revisiones son más severas, los ‘productos intelectuales’ publicados tienen un mayor nivel de acabado, y esos foros son los leídos por una comunidad científica más amplia. A falta de los datos relativos a citas cosechadas por investigadores que compiten por plazas, recursos económicos, becas, etc, se podría trabajar con los índices de impacto de las revistas donde estos publican. Si queremos difundir lo más posible nuestro trabajo de investigación, publiquemos en los sitios de más índice de impacto. Por tanto, SEGÚN DONDE PUBLIQUES ASÍ TE CITARÁN.

¡Ya, ya!, pero diferentes disciplinas no se pueden comparar

Esta afirmación está cargada de verdad ..., pero habría que matizar. Comparando áreas del conocimiento muy diferentes (e.g., Bioquímica vs Zoología, Ecología vs Antropología) esto es absolutamente cierto (ver el apartado de los ‘Sesgos en los índices de impacto’ y la Tabla 1). No obstante, y por experiencia propia y ajena, hay que reconocer que el campo de actuación de una determinada área de conocimiento es muy amplio. La atomización a la que conduce esta otra añagaza a la hora de definir perfiles de plazas, becas, proyectos, etc es aun mucho más grave y peligrosa por estar basada, en la mayoría de las ocasiones, en un soterrado nepotismo y vergonzante mediocridad. Baste un ejemplo: el autor de este trabajo ha tenido la posibilidad de publicar trabajos de aves y reptiles, de conducta animal y de ecología de comunidades / preferencias de hábitat, desde Ardeola y Amphibia-Reptilia, hasta Proc. Roy. Soc. London B y Ecology, pasando por Behaviour y Biological Conservation. Estas revistas cubren un amplio margen de índices de impacto que va desde 0 hasta 3 citas/año.

Otra queja habitual es que el tamaño de la comunidad científica sesga las tasas de citación (incluso dentro de un área de conocimiento como puede ser Ecología-Sistemática-Evolución). En principio sería aceptable que las disciplinas con más producción científica tuvieran más artículos referenciando bibliografía, y por tanto sería más fácil ser citados con mayor frecuencia (relación positiva entre tasa de citación y producción científica mundial). Por el contrario, también sería esperable encontrar una relación negativa entre citas/año y tamaño de la producción científica. Así, y habida cuenta de que la extensión de la bibliografía no cambia excesivamente entre disciplinas (existe un amplio solapamiento entre 10 y 90 referencias por artículo), también cabría esperar que las disciplinas con menos producción científica tuviesen en cuenta con mayor frecuencia los pocos trabajos existentes de los demás (el ‘síndrome de aldea’, donde casi todos se conocen de un modo u otro —congresos, por e-mail, por la lectura, por el menor tamaño de la base de datos de bibliografía—).

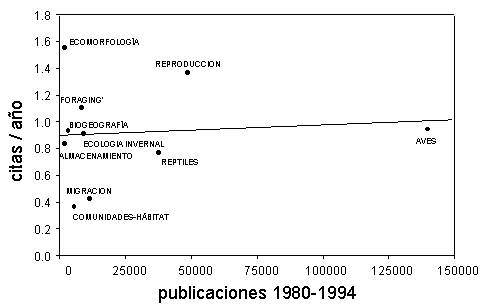

La Figura 5 muestra la relación existente entre las tasas de citación y el volumen de producción científica para distintas disciplinas eto-ecológicas, trabajando con una muestra que, aunque pequeña, es amplia temáticamente (tres investigadores, y 71 artículos citados, al menos, una vez). Para ello se han promediado los valores de citas/año de los trabajos que pueden ser asociados a 10 disciplinas atendiendo a su contenido. Mediante los Zoological Records en CD (años 1980-1994) se han contabilizado el volumen de la producción científica de estas disciplinas (incluyendo, además, revistas no contempladas por el Journal Citation Reports). Se han efectuado las búsquedas por palabras en los campos Título y Palabras Clave. Como puede verse, tasa de citación y volumen de la producción científica no están relacionados (¡¡ R2=0,00003 !!, n=10). Por tanto, dentro del Área de Ecología-Sistemática-Evolución, no puede afirmarse que el sesgo ‘volumen de producción científica’ tenga un efecto importante.

Conclusión: NO HAY DISCIPLINAS SIN REVISTAS DE ELEVADA DIFUSIÓN Y AMPLIO RECONOCIMIENTO POR LA COMUNIDAD CIENTÍFICA INTERNACIONAL. DIFERENCIAS EN EL TAMAÑO DE LA COMUNIDAD CIENTÍFICA EN DISCIPLINAS CONCRETAS DENTRO DE GRANDES ÁREAS DE CONOCIMIENTO PARECEN TENER POCA INFLUENCIA EN LAS EXPECTATIVAS DE SER CITADO EN LA BIBLIOGRAFÍA.

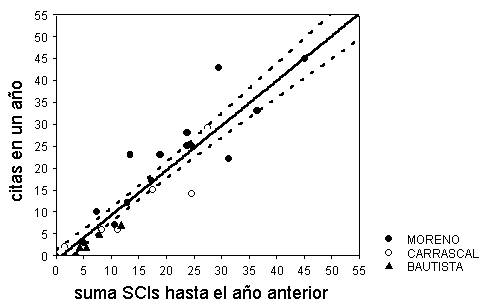

Para responder a esta pregunta, se anotó el número de veces que cada investigador era citado cada año desde la fecha de publicación de su primer trabajo en revistas incluidas en los Journal Citation Reports. También se calculó el sumatorio de los índices de impacto SCI de todos sus trabajos para los sucesivos años después de su primera publicación-SCI. La Figura 6 muestra la relación entre estas dos medidas (R2=0,89, n=34 años para tres investigadores). El modelo general obtenido para todos los años disponibles para los tres investigadores seleccionados fue:

TOTAL DE CITAS (año i) = 1,08 + 1,02 x S SCIj (hasta el año i-1)

donde j es un número desde 1 hasta el número de publicaciones acumuladas hasta ese año.

Los modelos fueron significativos para cada uno de los autores (p<<0,001), y no hubo diferencias significativas entre las pendientes de regresión (ANCOVA, p=0,721). Por tanto, e independientemente de las disciplinas de trabajo de cada investigador, los índices de impacto predicen correctamente cuánto va a ser citado cada investigador por la comunidad científica internacional. La tasa de citación por año no se vió afectada por los años transcurridos desde la publicación del primer artículo en revistas-SCI (correlación parcial entre citas/año con la ‘madurez’ —años transcurridos— excluyendo el efecto del sumatorio de SCIs = 0,17, p=0,81)

Conclusión: La suma de los índices de impacto de los trabajos publicados por un investigador puede ser utilizada como una medida de lo que se le está citando o citará. Este parámetro podría utilizarse incluso en fases tempranas de la carrera investigadora. SI QUIERES TENER UNA ELEVADA ‘UTILIDAD’ PARA LA COMUNIDAD CIENTÍFICA INTERNACIONAL, PUBLICA MUCHO CENTRÁNDOTE EN LAS REVISTAS DE MÁXIMO ÍNDICE DE CITACIÓN.

Las citas de los trabajos de investigación son una aproximación válida, aunque sesgada, de utilidad científica. Dentro de un mismo individuo, su empleo puede proporcionar una visión retrospectiva de cómo la inversión de tiempo, dinero e ilusiones está revirtiendo en la comunidad científica internacional. Este análisis puede ayudarnos a redirigir nuestros esfuerzos y modos de comunicar los resultados de nuestra investigación. No nos engañemos. Aunque con sutiles variaciones y genialidades aparte, somos investigadores medios en un mundo medio (si eres un genio estas letras no son para ti, pero ten en cuenta que todos los demás tenemos que reconocer tu genialidad). Por tanto, los índices de impacto de las revistas, calculados utilizando los trabajos de los demás, también son válidos a la hora de predecir las expectativas futuras de utilidad científica de nuestros artículos de investigación. Considerando el pretendido alcance y trascendencia de nuestros logros, debemos elegir los foros de publicación científica más adecuados. Tener en cuenta los índices de impacto de las revistas puede ayudarnos en esta decisión.

Aunque con sesgos, los índices de impacto de las revistas y las tasas de citación son de utilidad valorando el rendimiento científico de personas, grupos, o departamentos, el interés de revistas determinadas a la hora de comprarlas, etc. Son una herramienta de utilidad por tres motivos: su universalidad (contempla el uso por mucha gente en muchos países distintos), accesibilidad por todo aquel que quiera comprobarlo (disponible para consulta por todo aquel que quiera y se moleste en hacerlo), y valor predictivo. Son la mejor moneda de cambio a la hora de convencer a los políticos y gestores de la productividad y utilidad de nuestro trabajo. También son el mejor antídoto frente a la endogamia intelectual que, aunque bastante mitigada, aun campea por sus fueros en nuestro país. Si somos humildes, y la soberbia está excluida de nuestro carácter, deberemos reconocer que es menos probable que se confundan miles de investigadores leyendo y citando nuestro trabajo y el de los demás, que nuestras severas opiniones influidas por un entorno social concreto. Como todo en esta vida, el uso de las citas y los índices de impacto de las revistas debe ser efectuado con mesura e inteligencia. En manos de un necio puede producir un tremendo daño. Pero no es menos cierto que realmente sólo hace falta tener unos pocos conocimientos y dos dedos de frente para poderlo utilizar correctamente. Y ¿qué investigador que se precie, y quiera vivir de su trabajo en la universidad o centros de investigación, no puede asumir este pequeño reto?

Calow, P. (1997) Editor’s Report. Functional Ecology 11:1.

Day, R.A. (1994) How to write and publish a scientific paper. Cambridge Univ. Press, Cambridge.

Garfield, E. (1994a) The concept of Citation Indexing: A unique and innovative tool for navigating the research literature. Current Contents (print edition), January 3, 1994

Garfield, E. (1994b) The Impact Factor. Current Contents (print edition), June 20, 1994, 25:3-8

Garfield, E. (1994c) Expected citation rates, half-life, and impact ratios: comparing apples to apples in evaluation research. Current Contents (print edition), September 12, 1994.

Maddox, J. (1995) Plagiarism is worse than mere theft. Nature 376:721.

May, R.M. (1997) The scientific weath of nations. Science 275:793-796.

Metcalfe, N.B. (1995) Correspondence. Nature 376:720.

Ramón y Cajal, S. (1991) Reglas y consejos sobre investigación científica.12ª edición. Espasa Calpe, Madrid.

Rice, W. R. (1989) Analyzing tables of statistical tests. Evolution 43:223-225.

Sangalli, A. (1995) Is your publication really necessary? New Scientist, 28 October, 52-53.

Simonton, D.K. (1988) Scientific Genius. A psychology of science. Cambridge Univ. Press, Cambridge.

Tainer, J.A. (1991) Science, citation, and funding. Science 291:1408.

Wade, N. (1975) Citation analysis: a new tool for science administrators. Science 188:429-432.